La inteligencia artificial ha creado nuevos riesgos de plagio al permitir la creación rápida y fácil de texto.

La prevención puede incluir herramientas de detección de plagio y educación sobre ética y atribución en la producción de contenido, sin embargo, un estudio realizado por expertos de la Universidad de Maryland demostró que es matemáticamente imposible detectar de forma confiable un texto escrito por IA.

¿Por qué no es posible detectar de forma confiable un texto escrito por IA?

Por: Gabriel E. Levy B.

www.andinalink.com

La facilidad con la que la inteligencia artificial (IA) genera texto que parece escrito por humanos ha dado lugar a una serie de problemas que afectan tanto al mundo académico como al público en general.

Un ejemplo de ello es el engaño en ensayos y exámenes, lo que lleva a cuestiones éticas y a un posible menoscabo de la calidad de la educación.

Ante estas preocupaciones, algunos expertos han propuesto métodos para detectar y protegerse contra el uso malintencionado de texto generado por IA. Uno de estos métodos es la inserción de marcas de agua ocultas en la salida de la IA, lo que permitiría a los usuarios verificar la fuente de los textos. Sin embargo, esta técnica puede no ser efectiva en casos de parafraseo de texto generado por IA, ya que este tipo de herramientas pueden reducir drásticamente la efectividad de las marcas de agua.

Otra técnica propuesta es el análisis de patrones que solo se producirían en un texto generado por IA. Sin embargo, a medida que los modelos de IA mejoran, las salidas de lenguaje se vuelven cada vez más similares al habla humana, lo que hace que sea más difícil detectar estos patrones.

La investigación en la Universidad de Maryland

Una investigación liderada por el experto académico: Soheil Feizi y su equipo en la Universidad de Maryland, ha demostrado matemáticamente que la detección confiable de texto generado por IA es en realidad imposible[1].

El problema radica en la capacidad de los modelos de IA para generar texto que se asemeja al habla humana, lo que reduce la efectividad de los métodos de detección existentes.

Además, los modelos de IA mejoran continuamente, lo que significa que las salidas de lenguaje generadas por IA se vuelven cada vez más similares a las producidas por humanos, lo que dificulta aún más la detección de texto generado por IA.

Para demostrar esta limitación, Feizi y su equipo utilizaron herramientas de parafraseo basadas en Inteligencia Artificial para reformular texto generado por IA, con y sin marcas de agua, y lo alimentaron en varios detectores de texto.

Descubrieron que la precisión de la mayoría de los detectores se redujo a casi el 50 por ciento, lo que significa que estos métodos son tan precisos como lanzar una moneda al aire.

Además, los investigadores utilizaron una prueba matemática llamada resultado de imposibilidad para demostrar que, a medida que los modelos de IA se vuelven más similares a los humanos en la distribución de palabras en el texto que generan, los detectores tendrán dificultades para manejarlos. Esto significa que identificarán muchos falsos positivos o no lo suficiente, permitiendo que el texto de IA pase desapercibido[2].

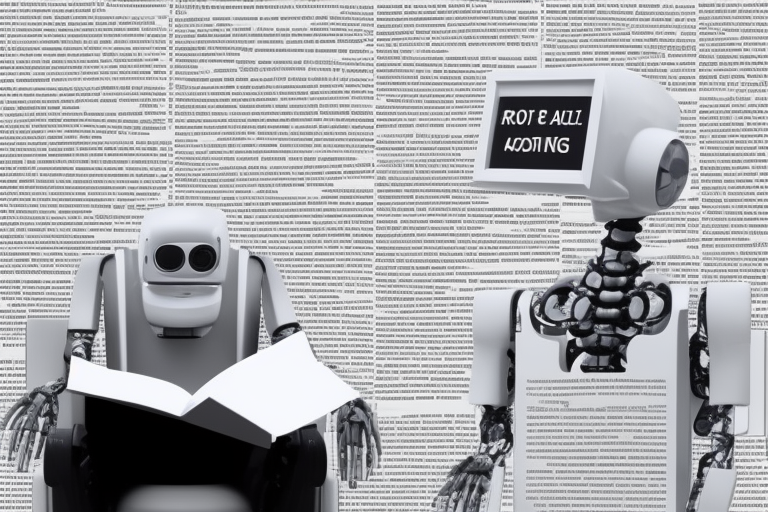

El mayor riesgo es la desinformación

Aunque puede resultar muy preocupante el plagio en entornos académicos y se ha convertido en un verdadero calvario para los docentes e investigadores, el mayor problema sin duda reside en el campo de la desinformación.

Los sistemas de inteligencia artificial (IA) como Chat GPT, que son capaces de generar y parafrasear lenguaje con gran facilidad, han demostrado ser una herramienta potencialmente poderosa para aumentar los niveles de desinformación en la población. Esto se debe a que los generadores de texto de IA pueden ser utilizados para crear contenidos falsos o engañosos, lo que dificulta la distinción entre información verdadera y falsa.

Además, la capacidad de los sistemas de IA para producir grandes cantidades de texto en poco tiempo, junto con su habilidad para adaptarse a diferentes estilos de lenguaje y estructuras de información, puede contribuir aún más a la propagación de desinformación en línea.

Un abordaje Integral y regulatorio

La regulación adecuada de los sistemas de inteligencia artificial (IA) es fundamental para prevenir el mal uso y disminuir el riesgo de la desinformación en la sociedad. La IA tiene un gran potencial para beneficiar a la sociedad, pero también puede ser utilizada para fines malintencionados, como la creación y propagación de contenidos falsos y engañosos. Como resultado, es importante que se establezcan marcos regulatorios efectivos para garantizar que la IA se utilice de manera ética y responsable.

Una regulación adecuada de la IA puede incluir el establecimiento de normas éticas y de seguridad para el desarrollo, la implementación y el uso de sistemas de IA. Esto puede incluir la evaluación de riesgos y la identificación de soluciones para abordar posibles problemas y garantizar que los sistemas de IA se utilicen de manera responsable y transparente. Además, una regulación adecuada también puede garantizar que los sistemas de IA sean accesibles y equitativos para todos los usuarios.

Por lo tanto, es importante que los gobiernos y los actores relevantes de la industria trabajen juntos para desarrollar marcos regulatorios innovadores y adecuados ante los desafíos que representa una tecnología que está transformando sustancialmente el mundo de las comunicaciones

Adicionalmente una adecuada colaboración entre los reguladores y los desarrolladores de la IA para garantizar que se establezcan estándares éticos y de seguridad claros, es indispensable durante los próximos años.

En Conclusión, la facilidad con la que los sistemas de inteligencia artificial pueden generar y parafrasear lenguaje ha creado nuevas preocupaciones sobre la integridad académica y ética en la producción de contenido. Aunque se han desarrollado herramientas de detección de plagio, recientes investigaciones llevadas a cabo por Soheil Feizi y su equipo en la Universidad de Maryland sugieren que estos métodos pueden no ser confiables. En una prueba matemática, demostraron que la detección confiable de texto generado por IA es en realidad matemáticamente imposible.